Configuração da Rede SAN (Storage Área Network)

Jornada Proxmox Parte 3 – Storage SAN no Proxmox VE

Versão 1

Emissão: 14 de setembro de 2022

Validade: Indeterminada

Tema: Proxmox Storage Área Network

Objetivo

Hoje iremos orientar a equipe técnica na configuração do Proxmox Storage Área Network, ou seja, nossa rede SAN. A integração nativa que a Proxmox disponibiliza com Ceph visa, mais uma vez, simplificar a vida do administrador de rede, mas algumas premissas precisam ser cumpridas. Para configuração do nosso cluster Ceph precisamos de discos montados em redundância e de modo compartilhado para garantia da alta disponibilidade com live migration. Vamos continuar usando os três servidores Proxmox montados no nosso laboratório iniciados nas partes 1 e 2 dessa jornada. Desse modo esse material visa resolver a seguinte questão: Como preparar o Proxmox para receber a funcionalidade de Storage Ceph?

Importante lembrar que montamos mais este material conforme o treinamento oficial de Proxmox da RunbookBR. Não comercializamos o material, portanto, estando restrito a aplicação para nossas equipes internas.

Pré-Requisitos para nosso Proxmox Storage SAN

- De antemão é importante que você tenha realizado os passos da parte 1 da Jornada Proxmox da RunbookBR.

- Do mesmo modo, é providencial ter concluído a parte 2 da Jornada.

- Também recomendo que você possua conhecimento básico em redes de computadores e familiaridade com termologias relacionadas a tecnologia da informação.

- Para melhor aproveitamento desse material é importante que se tenha montado um ambiente com pelo menos três servidores Proxmox instalados.

Topologia montada para o Cluster Proxmox Storage Ceph

Lembrando que dispomos no nosso ambiente de lab: 2 servidores Intel Xeon E31270, all flash com oito discos SSD e duas interfaces de rede Gigabit Ethernet cada e 16 GB RAM.

Assim como, temos montado no nosso Rack um desktop Intel Core i5 2400 com um disco mecânico e 16 GB RAM e uma interface de rede.

Vlan para Cluster Proxmox Storage Ceph?

Antes de iniciar a configuração do Ceph, recomendo configurar uma segunda interface de rede para ficar dedicada ao serviço de dados. Escreverei outro artigo detalhando melhor esse assunto. Mas por hora, partirei da premissa que teremos um tráfego de dados muito grande concorrendo com nossa rede LAN. Em linhas gerais, é boa prática segregar sua rede SAN (Storage área Network) da sua rede LAN (Local área Network). Para tanto podemos adotar a estratégia de separar fisicamente as redes, com swtiches distintos, ou podemos trabalhar com vlans. Como não iremos abordar o tema vlan nesse artigo, vamos simplificar nossa estrutura utilizando dois switches físicos distintos.

Desse modo, quando eu me referir a rede LAN, estou falando das conexões do meu servidor Proxmox conectadas ao switch 1. Por outro lado, quando eu falar da rede SAN, estou me referindo a uma segunda interface configurada no Proxmox, onde a conexão física no nosso cenário estará ligada ao switch 2.

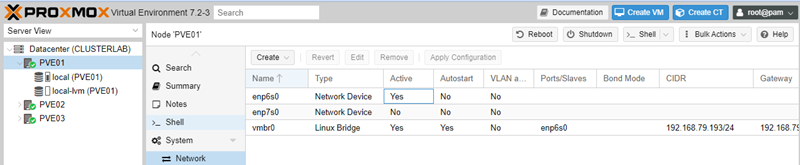

Padrão de interface no Proxmox

Desse modo, precisamos entender que o Proxmox, por padrão, habilita apenas a interface LAN, vamos configurar antes de qualquer coisa, uma segunda interface, dessa vez, para nossa rede SAN. Então, vamos aplicar a configuração referida neste artigo para todos os nós que atenderão pelo serviço do Ceph e essa segunda interface precisa estar ligada fisicamente no nosso segundo switch (switch dedicado da rede SAN).

Criando uma interface Bridge no Proxmox

Tipos de interfaces no Proxmox

Antes de começar a configurar nossa segunda interface, vamos fazer um resumo das principais opções que o Proxmox nos traz.

Linux Bridge

Antes de mais nada, preciso que você entenda que Linux Bridge é a configuração padrão do Proxmox. Se considerarmos a tradução literal, entenderemos que esse modo de configuração é literalmente uma “ponte” entre o meu recurso lógico e minha placa de rede física. Nesse contexto, podemos ter o host e/ou as máquinas virtuais compartilhando a mesma placa de rede física como se fosse sua. É como se um switch virtual fosse conectado na interface física do meu servidor, compartilhando aquela conexão de saída para os meus recursos lógicos.

Linux Bond

Para resumir, nós utilizamos essa técnica quando queremos configurar agrupamento de interfaces físicas em uma única interface lógica. Esse cenário é muito comum em ambiente de produção porque pode resolver alguns problemas como:

- Aumento de largura da banda limitada pela interface

- Melhoria da disponibilidade com uso de uma interface principal e outra failover (por exemplo)

Existem alguns modos de uso para configuração do seu link aggregation ou como podemos ver como referência em algumas bibliografias, “NIC Team”. Assim, deixarei como referência, a pagina wiki da Proxmox.

Configuração da interface secundária, Proxmox Storage SAN

Vamos configurar uma “interface bridge”, sem agrupamento ou balanceamento. Como nossos servidores possuem apenas duas interfaces de rede, vamos trabalhar com interfaces simples, uma interface LAN e outra SAN.

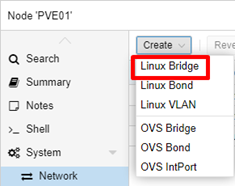

Create ⇾ Linux Bridge

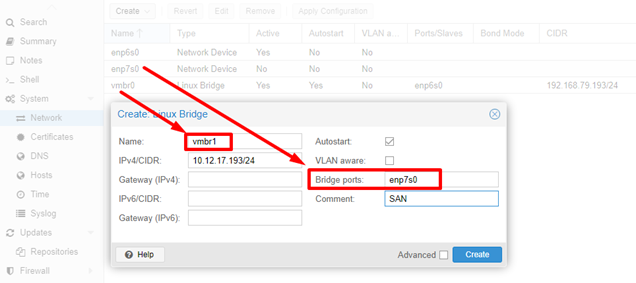

Para configuração da nova interface, perceba que além do IP, precisamos associar nossa interface física, identificando de maneira única também nossa interface lógica.

As interfaces do tipo “Network Device” são nossas interfaces físicas, então defina em Bridge Ports qual a interface que atenderá pela rede SAN. Linux Bridge é nossa interface virtual, como o Proxmox configurou apenas uma interface vmbr0, siga a sequência e configure a vmbr1.

Configure o IP Address, claro

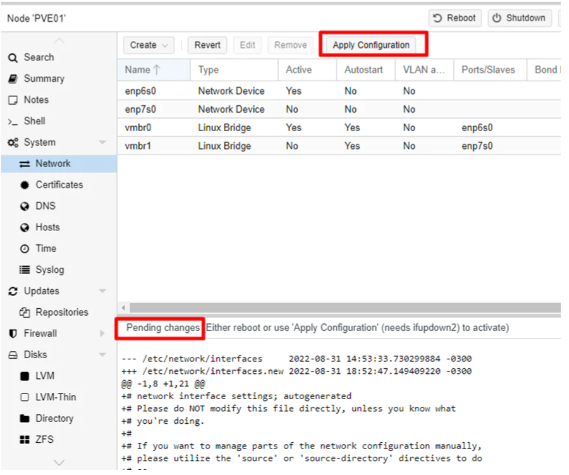

Todavia, perceba nos logs da configuração que existem mudanças pendentes, clique em Apply Configuration para finalizar a configuração da interface.

Além disso, repita o procedimento para os demais servidores do cluster. Lembrando que vamos aplicar um IP único para cada nó (no nosso exemplo configuramos apenas dois servidores com acesso à rede SAN). Em caso de dúvidas de como nós montamos a topologia, revise a sessão “Topologia proposta para o laboratório”.

Validação de interfaces Proxmox Storage SAN

Precisamos agora validar a comunicação dos servidores a partir da segunda interface que corresponde a sua rede SAN. Importante lembrar que a rede SAN é uma rede IP assim como nossa rede LAN, por tanto o procedimento de validação seguirá da mesma forma. Portanto, acessaremos o shell do servidor PVE01. É esperado que por padrão a rede SAN responda a ping.

Caso sua rede não esteja comunicando, preciso que você pare esse artigo e entenda a causa da falha de comunicação na sua rede. Revise seu cabeamento, suas configurações de vlan se for o seu caso. Não siga sem resolver a comunicação pela rede SAN.

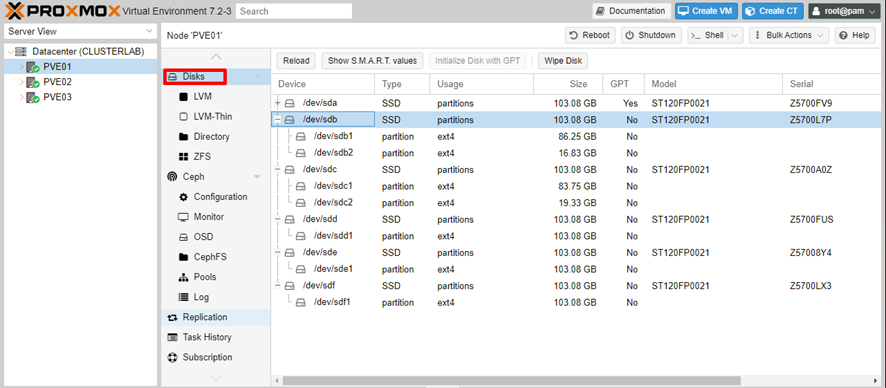

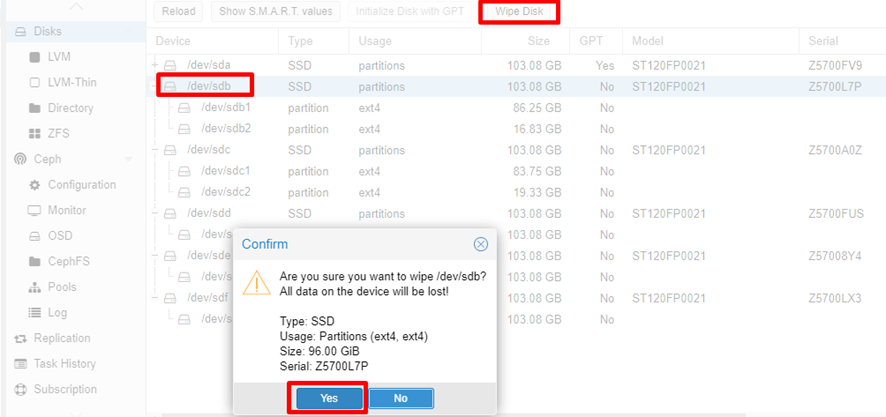

Preparação dos discos Proxmox Storage

Agora, vamos garantir que os discos estejam livres nas configurações de partições de sistema. Vamos seguir com os passos necessários para termos o Ceph reconhecendo os discos que serão montados no seu Pool.

Vamos garantir a liberação dos discos com os passos abaixo.

Acesse a configuração dos discos

Neste ínterim, faça o wipe disk para todos os discos que serão disponibilizados para o cluster Ceph.

Atenção, o sda foi utilizado para o sistema operacional conforme apresentado na parte 1 dessa Jornada.

Repita os passos no outro servidor que contém discos para serem disponibilizados para o cluster Ceph. Lembrando que no nosso laboratório, deixei o PVE03 sem discos para disponibilizar, ele será usado apenas como nó de monitoramento do serviço. Desse modo, iremos realizar o wipe disk apenas nos servidores PVE01 e PVE02.

Conclusão

Enfim, vimos no artigo de hoje o passo a passo de como configurar as premissas necessárias para montagem de cluster Proxmox Storage Ceph. Entendemos alguns conceitos básicos de como funciona e como parametrizar suas interfaces SAN. Nosso ambiente de alta disponibilidade já tem os pré-requisitos para instalação do nosso serviço Ceph. Então, para um cluster PVE totalmente funcional, um storage Ceph para armazenar nossas máquinas virtuais e containers, aguarde a próxima publicação onde fazermos o passo a passo da instalação do serviço Ceph no seu cluster Proxmox.

Acompanhe os próximos artigos dessa jornada que mostrará todas as etapas que precisam ser realizadas para alcançarmos nosso cenário proposto e termos nosso ambiente com 99,99% de disponibilidade.

Na parte 4 dessa jornada iremos fazer uma abordagem conceitual sobre o Ceph.

Não deixe de dar uma conferida no nosso canal no YouTube, até a próxima.

Ola

Primeiramente belo trabalho e otimos conteudo.

Uma duvida se caso eu tiver um cenario com 3 servidores com 8 discos cada servidor, devo fazer RAID Hardware por exemplo e depois aplicar os passos ?

ou

Realizar todos os passos e implantar o proxmox com cluster e HA que ele ira fazer o “papel” que o RAID por hardware realiza?

Obrigado desde ja.

Oi Renan, antes de mais nada fico muito feliz que você tenha apreciado nosso trabalho. A RunbookBR se emprenha em fazer o melhor trabalho possível para agregar valor real aos profissionais que nos acompanham ou simplesmente nos acham nos mecanismos de busca 🙂

Com relação a sua dúvida, vou responder em algumas partes.

Não é necessário fazer RAID por Hardware para utilização do Ceph. O Próprio Ceph se encerregará de fazer todo trabalho de paridade entre os três nós, utilizando os discos que você disponibilizará.

Os próximos dois artigos detalharão o exposto acima.

Adicionalmente te convido a acessar a Jornada Proxmox no Youtube. Conseguimos fechar bastante material sobre esse tema e essa parte em especial eu diria que está concluida e pode responder de maneira mais prática a sua pergunta uma vez que mostro todo passo a passo, além de passar a parte conceitual de uma forma um pouco diferente do que temos no nosso blog.

O conteúdo é basicamente o mesmo, mas a abordagem é diferente. Então fica como opção 🙂

https://www.youtube.com/channel/UCfB6XJlNw0PDHF0seOBhsUw?sub_confirmation=1

Playlist da Jornada Proxmox da Runbookbr: https://youtube.com/playlist?list=PLWK3SH6DBDWbUr8roMnPuuBE3nOyRzEuf